歡迎您光臨深圳塔燈網絡科技有限公司!

余先生:13699882642

余先生:13699882642

發表日期:2019-11 文章編輯:小燈 瀏覽次數:5125

學完 DeepLearning 系列課程后就想做一個小應用試試。一開始基于 RNN 訓練了個古詩機器人,這個做的人很多,于是換了宋詞。宋詞是基于詞牌生成,相對數據量比較少,基于 RNN 訓練效果很一般。后來了解到了 Transformer 算法感覺發現了生機,訓練了一下感覺效果真是不錯。

使用效果測試的話可以直接掃碼訪問這個小程序玩玩, 或者小程序搜索 【小詩一首】:

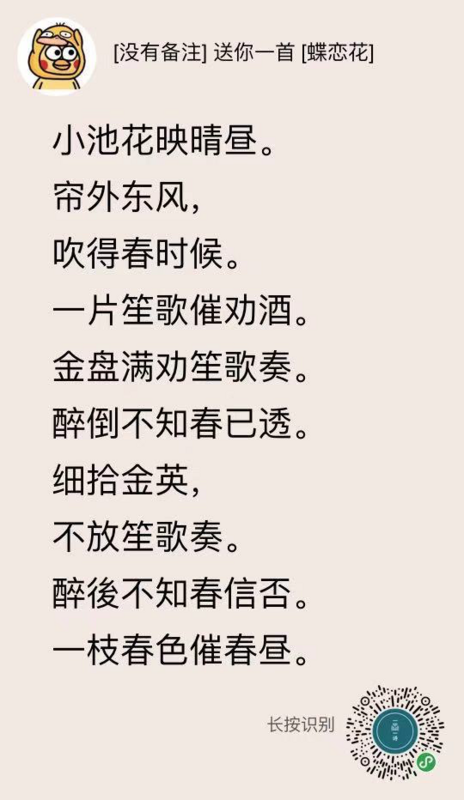

這是生成的例子:

Transformer 是 Google 于 2017 年在 Attention Is All You Need 論文中提出,基于 Attention 機制,在機器翻譯及其他語言理解任務有著以往無法比擬的效果,后 2018 年又提出 Universal Transformer, 在多項有難度的語言理解任務上泛化效果明顯更好。Transformer 解決 RNN 存在的長序列信息丟失的問題,像宋詞這種講究格式講究押韻的語句,在 RNN 中就很難訓練到好的效果,但是 Transformer 就可以很好的提取訓練宋詞中的格式以及押韻特征。

想深入學習 Transformer 以及算法可以看 Tensorflow 官方的教程. 等下篇文章我也詳細介紹如何基于 Transformer 訓練一個宋詞機器人,包括如何預處理訓練數據,如何使用模型生成序列文本。

日期:2019-11 瀏覽次數:5630

日期:2019-11 瀏覽次數:12087

日期:2019-11 瀏覽次數:4449

日期:2019-11 瀏覽次數:5496

日期:2019-11 瀏覽次數:5346

日期:2019-11 瀏覽次數:7326

日期:2019-11 瀏覽次數:5256

日期:2019-11 瀏覽次數:15877

日期:2019-11 瀏覽次數:4833

日期:2019-11 瀏覽次數:6623

日期:2019-11 瀏覽次數:5501

日期:2019-11 瀏覽次數:4672

日期:2019-11 瀏覽次數:10919

日期:2019-11 瀏覽次數:8442

日期:2019-11 瀏覽次數:5179

日期:2019-11 瀏覽次數:4422

日期:2019-11 瀏覽次數:9082

日期:2019-11 瀏覽次數:4762

日期:2019-11 瀏覽次數:4959

日期:2019-11 瀏覽次數:4965

日期:2019-11 瀏覽次數:4618

日期:2019-11 瀏覽次數:5123

日期:2019-11 瀏覽次數:10409

日期:2019-11 瀏覽次數:5563

日期:2019-11 瀏覽次數:5560

日期:2019-11 瀏覽次數:5003

日期:2019-11 瀏覽次數:12473

日期:2019-11 瀏覽次數:7471

日期:2019-11 瀏覽次數:8031

日期:2019-11 瀏覽次數:4952

Copyright ? 2013-2018 Tadeng NetWork Technology Co., LTD. All Rights Reserved.